¡Use AI para calificar la calidad de imagen del juego! Intel lanza una nueva herramienta de evaluación CGVQM

Intel abrió recientemente la herramienta de evaluación de calidad de video basada en AI CGVQM (indicadores de calidad visual de gráficos de computadora) en GitHub, con el objetivo de proporcionar estándares cuantitativos objetivos para juegos y representación de imágenes en tiempo real. La herramienta se publica en forma de Pytorch, y los trabajos de investigación de apoyo se publican simultáneamente.

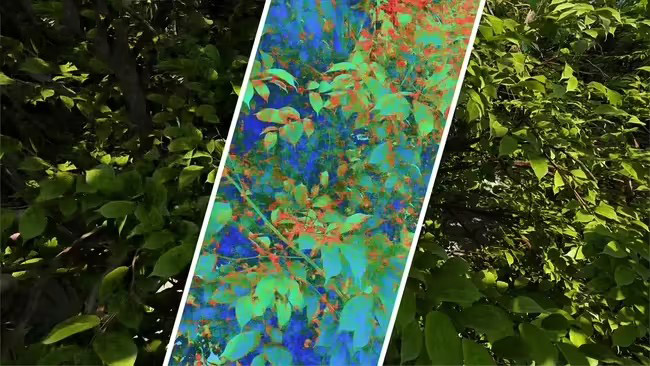

Los juegos actuales generalmente dependen de tecnologías de supercota como DLS para mejorar el rendimiento, pero son propensos a causar problemas visuales como el fantasma y el parpadeo. Los indicadores de calidad de imagen tradicionales (como PSNR) solo evalúan los artefactos de compresión y no pueden reflejar completamente la distorsión compleja de la representación en tiempo real. Con este fin, el equipo de Intel construyó un conjunto de datos CGVQD, que cubre la degradación diversificada de la calidad de la imagen causada por tecnologías como el rastreo de rutas e hipers muestreación neuronal, y capacitó el modelo CGVQM basado en este conjunto de datos. Este modelo adopta una red neuronal convolucional 3D (arquitectura 3D-Resnet-18), que puede capturar simultáneamente las características de la imagen en las dimensiones del espacio-tiempo e identificar con mayor precisión los problemas dinámicos de calidad de imagen.

Los experimentos muestran que el efecto de evaluación CGVQM excede de manera integral las herramientas existentes: la versión compleja de CGVQM-5 está cerca de la línea de base de la puntuación humana, y la versión simplificada de CGVQM-2 también está firmemente entre los tres primeros, y ha mostrado una buena capacidad de generalización en los videos no capacitados. En el futuro, el rendimiento del modelo se puede optimizar aún más mediante la introducción de la información de transformador o flujo óptico.